Infos im Internet: Was ist wichtig, was ist richtig?

Das Internet sammelt das Wissen der Welt, Informationen stehen in Überfülle bereit. Nur: Bekommen wir im Netz auch die richtigen Antworten auf unsere Fragen, enthalten sie alle relevanten Informationen? Dieses Problems nimmt sich die Fakultät für Informatik der Freien Universität Bozen an und hat auch schon interessante Lösungswege gefunden.

War früher noch der fehlende Zugang zu Informationen das größte Problem, ist es heute der Überfluss. Zu allem und jedem liefert das Internet Informationen zuhauf, für den Einzelnen ist es unmöglich geworden, alle Dokumente zu einem Thema zu lesen, zu analysieren, abzugleichen, Relevantes herauszufiltern und Unwichtiges oder Unsinniges zu eliminieren. Selektion ist demnach zur wichtigsten Aufgabe des Internetnutzers geworden und trotzdem bleibt immer die Frage: Habe ich auch wirklich alle wichtigen Informationen gefunden?

Um die Aufgabe des Selektionierens und Extrahierens von Informationen im Internet zu erleichtern oder überhaupt erst ein Scannen aller Quellen zu ermöglichen, setzt man heute mehr und mehr auf die Technik. So genannte Extraktoren durchforsten selbständig die Fülle vorhandener Texte zu einem Thema und fassen die darin erfassten Informationen zusammen. „Damit wir aber wissen, ob die Extraktoren wirklich alle Informationen erfasst haben, die wichtig und sinnvoll sind, braucht es Prüfverfahren“, erklärt Werner Nutt, Professor an der Informatik-Fakultät der unibz.

Maschinen als Qualitätsprüfer

Was es also braucht, ist eine Qualitätskontrolle, damit sichergestellt ist, dass die gefundenen Informationen auch halten, was sie versprechen. An der unibz werden daher einerseits Extraktoren entwickelt, etwa solche, die relevante Infos aus Hotelbewertungen im Internet herausfischen und zugänglich machen. So spart man sich das Scrollen durch alle Nutzer-Kommentare und kann diese auf relevante Informationen hin durchsuchen: Ist das Frühstück gut? Ist es im Preis inbegriffen? Stört der Straßenlärm?

Andererseits arbeitet man an der unibz auch an Verfahren zur Prüfung der Informationen auf Vollständigkeit und Wichtigkeit. Da gilt es zuallererst, Grundlagenarbeit zu leisten: „Das Problem der Vollständigkeit und Wichtigkeit der Daten in Wissensbanken taucht zwar immer wieder auf, trotzdem fehlen bis dato grundsätzliche Untersuchungen dazu“, erklärt Nutt. Einen ersten Schritt zur Schließung dieser Lücke hat Professor Nutt mit seinem ehemaligen unibz-Kollegen Simon Razniewski und Vevake Baralaman von der Uni Trient gesetzt, indem sie viel genutzte Wissensbanken – etwa Wikidata – und die darin enthaltenen Informationen unter die Lupe genommen haben. „Wissensbanken haben das Ziel, das gesamte Wissen der Welt zu erfassen“, sagt Nutt, „weil dies aber unmöglich ist, werden sie immer unvollständig sein“. Das Problem sei demnach weniger, für Vollständigkeit zu sorgen, als vielmehr dafür, dass die wichtigsten Informationen bereitgestellt würden.

Was ist überhaupt, wichtig?

Die Frage ist dann allerdings auch: Was ist wichtig? Welche Informationen müssen etwa zu einem Menschen in einer Wissensbank gesammelt und bereitgestellt werden, damit die Daten als „vollständig“ gelten, also alles Wichtige greifbar ist? Und ist jede Information über jeden Menschen von gleicher Bedeutung? In ihrem Paper „Doctoral Advisor or Medical Condition: Towards Entity-specific Rankings of Knowledge Base Properties“ führen die drei Autoren ein Beispiel dafür an, dass dies nicht der Fall ist. Während nämlich für einen Politiker die Information über die Parteizugehörigkeit wichtig sei, sei sie für einen Musiker marginal. Über diesen sei es wichtiger zu wissen, welche Instrumente er spiele. Und ist die Zahl der geschossenen Tore für Lionel Messi oder Cristiano Ronaldo zentral, ist sie für Papst Franziskus eher nebensächlich – auch wenn er in der Jugend Fußball gespielt hat.

Welche Information wichtig ist oder nicht, variiert demnach von Person und Person. „Was es braucht, um Wichtiges von Unwichtigem zu unterscheiden, ist Hausverstand“, sagt Professor Nutt. Und genau darin liegt das Problem: Maschinen fehlt dieser Hausverstand, er muss durch andere Verfahren ersetzt werden. Derzeit sind unterschiedliche in Gebrauch, rein statistische etwa oder solche, die die Anzahl von Google-Treffern als Messwert für wichtig oder unwichtig heranziehen. Alle diese Verfahren lieferten in den Tests von Razniewski, Baralaman und Nutt aber nur ungenügende Ergebnisse. Während menschliche Testpersonen bei der Unterscheidung von wichtig und unwichtig Übereinstimmungen von 80 bis 90 Prozent erzielten, kamen die getesteten bekannten Verfahren auf Prozentsätze zwischen 50 und 65 Prozent. „Unsere Frage war deshalb: Kann man das besser machen?“, so Nutt.

"Was es braucht, um Wichtiges von Unwichtigem zu unterscheiden, ist Hausverstand"

Maschinen Hausverstand beibringen

Die Zielsetzung für Nutt und seine Kollegen war deshalb klar: „Wir wollten versuchen, mehr Intelligenz in dieses System zu bringen“, so der unibz-Professor, „und zwar mit maschinellem Lernen“. Wenn er also schon keinen Hausverstand hat, will man dem Computer etwas ähnliches, möglichst gleichwertiges beibringen und dafür gibt es zwei Möglichkeiten. Die erste ist das überwachte Lernen, bei dem dem Computer möglichst viele Beispiele gegeben werden, wie Menschen in bestimmten Fällen Entscheidungen treffen. „Daraus erstellt der Computer dann Regeln, denen er selbst bei der Entscheidungsfindung folgt“, so Nutt. Im vorliegenden Fall kam dies aufgrund der Komplexität der Informationen nicht in Frage.

Zweite Möglichkeit des maschinellen Lernens ist das „transfer learning“. „Man zieht die Erkenntnisse aus einem verwandten Bereich heran und versucht, diese auf den Untersuchungsbereich anzuwenden“, erklärt der Professor, der diesen Weg mit seinen Kollegen eingeschlagen hat. So wurden Wikipedia-Einträge semantisch analysiert, um zu eruieren, welche Begriffe häufig verwendet werden, um ein bestimmtes Thema zu beschreiben. Kommen demnach in einem Artikel über eine Person Begriffe wie „Wahlen“, „gewählt“ oder „Partei“ vor, hat diese Person höchstwahrscheinlich mit Politik zu tun. „Danach gleicht der Computer den Wissensbank-Eintrag mit den für den Bereich Politik als wichtig definierten Informationen ab und kann eruieren, inwieweit alle relevanten Informationen vorhanden sind“, so Nutt. Mit dem semantischen Ansatz konnte die Zuverlässigkeit zwar gesteigert werden, aber noch immer waren die Ergebnisse nicht die, die man sich erwartet hatte.

Der Mix macht’s

Die besten Ergebnisse lieferten nicht einzelne Verfahren allein, sondern eine Kombination aus unterschiedlichen bekannten und neuen. So konnten „Trefferquoten“ von rund 75 Prozent erreicht werden. „Aber auch diese Ergebnisse sind noch nicht ideal“, erklärt der Professor, der weiß: das Problem der Prüfung der Informationen in Wissensbanken auf Vollständigkeit und Wichtigkeit ist noch nicht gelöst. Die Lösung war allerdings auch nicht zu erwarten: „Wir wollten das Problem umfassend darstellen, Interesse dafür wecken und Wege zur Lösung andenken“, so Nutt.

Das ist dem Forscherteam auf der Achse Bozen-Trient in jedem Fall gelungen, es wurde weitere Grundlagenarbeit für die sinnvolle Nutzung der Informationsfülle im Internet geleistet. Bis allerdings ein valides Instrument zur Qualitätskontrolle fehlt, kann auch die für den Nutzer wichtige Frage nicht beantwortet werden, ob die aus dem Internet extrahierten Informationen auch wirklich alles Wichtige wiedergeben und dies in einer sinnvollen Art und Weise tun. Und bis dahin wird man auch an der unibz weiter den Fragen nachgehen: Wie kann man Informationen aus Texten im Internet extrahieren? Wie kann man überprüfen, ob diese Informationen vollständig sind? Und wie kann man sicherstellen, ob die automatisch generierte Antwort auf eine Frage im Internet vollständig, sinnvoll und richtig beantwortet wurde?

Related Articles

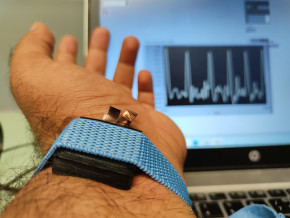

Tecno-prodotti. Creati nuovi sensori triboelettrici nel laboratorio di sensoristica al NOI Techpark

I wearable sono dispositivi ormai imprescindibili nel settore sanitario e sportivo: un mercato in crescita a livello globale che ha bisogno di fonti di energia alternative e sensori affidabili, economici e sostenibili. Il laboratorio Sensing Technologies Lab della Libera Università di Bolzano (unibz) al Parco Tecnologico NOI Techpark ha realizzato un prototipo di dispositivo indossabile autoalimentato che soddisfa tutti questi requisiti. Un progetto nato grazie alla collaborazione con il Center for Sensing Solutions di Eurac Research e l’Advanced Technology Institute dell’Università del Surrey.

unibz forscht an technologischen Lösungen zur Erhaltung des Permafrostes in den Dolomiten

Wie kann brüchig gewordener Boden in den Dolomiten gekühlt und damit gesichert werden? Am Samstag, den 9. September fand in Cortina d'Ampezzo an der Bergstation der Sesselbahn Pian Ra Valles Bus Tofana die Präsentation des Projekts „Rescue Permafrost " statt. Ein Projekt, das in Zusammenarbeit mit Fachleuten für nachhaltiges Design, darunter einem Forschungsteam für Umweltphysik der unibz, entwickelt wurde. Das gemeinsame Ziel: das gefährliche Auftauen des Permafrosts zu verhindern, ein Phänomen, das aufgrund des globalen Klimawandels immer öfter auftritt. Die Freie Universität Bozen hat nun im Rahmen des Forschungsprojekts eine erste dynamische Analyse der Auswirkungen einer technologischen Lösung zur Kühlung der Bodentemperatur durchgeführt.

Gesunde Böden dank Partizipation der Bevölkerung: unibz koordiniert Citizen-Science-Projekt ECHO

Die Citizen-Science-Initiative „ECHO - Engaging Citizens in soil science: the road to Healthier Soils" zielt darauf ab, das Wissen und das Bewusstsein der EU-Bürger:innen für die Bodengesundheit über deren aktive Einbeziehung in das Projekt zu verbessern. Mit 16 Teilnehmern aus ganz Europa - 10 führenden Universitäten und Forschungszentren, 4 KMU und 2 Stiftungen - wird ECHO 16.500 Standorte in verschiedenen klimatischen und biogeografischen Regionen bewerten, um seine ehrgeizigen Ziele zu erreichen.

Erstversorgung: Drohnen machen den Unterschied

Die Ergebnisse einer Studie von Eurac Research und der Bergrettung Südtirol liegen vor.